- Mark Ren

-

-

-

随着人工智能在医疗、金融、零售、语音识别等敏感领域的深入落地,传统的集中式建模方式面临了前所未有的挑战:

- 📉 数据无法集中共享:医疗机构、企业组织受限于合规(如 GDPR、HIPAA)禁止将数据上传云端

- 🔐 隐私保护成为核心需求:越来越多的用户期望“在不暴露数据”的前提下享受 AI 服务

- 📲 终端智能设备兴起:手机、IoT 设备成为数据产生的重要源头,模型也应“随数据而去”

在这些背景下,**联邦学习(Federated Learning, FL)**成为一种被广泛认可的解决方案。

它允许数据保留在本地,通过模型参数交换来完成协同训练 —— 兼顾模型性能与隐私保护,正在成为 AI 未来的重要架构基础。

一、什么是联邦学习?

联邦学习是一种分布式机器学习框架,其核心思想是在不共享原始数据的情况下,通过将模型训练过程分布到多个本地设备或服务器上,协同构建一个全局模型。这种方法最早由谷歌在2016年提出,旨在解决数据孤岛和隐私保护的问题。

与传统的集中式机器学习相比,联邦学习具有以下特点:

- 数据本地化:数据始终保留在本地设备上,避免了数据在网络上传输的风险。

- 模型共享:各参与方仅共享模型参数或梯度,而非原始数据。

- 隐私保护:通过技术手段(如差分隐私、加密计算等)增强数据的隐私性。

这种框架特别适用于医疗、金融、移动设备等对数据隐私要求较高的领域。

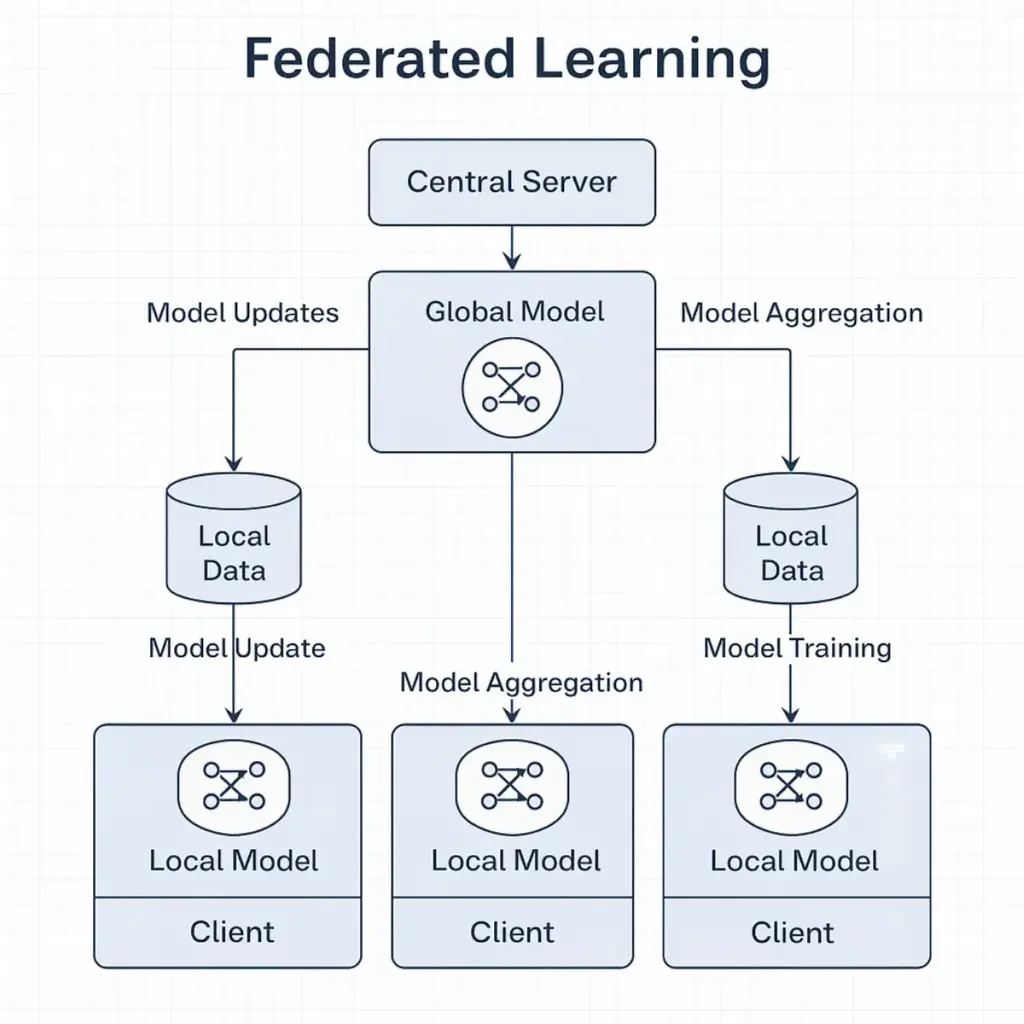

联邦学习的工作流程

联邦学习的典型工作流程包括以下步骤:

- 初始化全局模型:中央服务器初始化一个全局模型,并将其发送给各参与方。

- 本地模型训练:各参与方使用本地数据对接收到的模型进行训练,得到本地模型更新。

- 上传模型更新:各参与方将本地模型的更新(如梯度或权重)发送回中央服务器。

- 聚合模型更新:中央服务器对所有参与方的模型更新进行聚合(如加权平均),更新全局模型。

- 迭代训练:重复上述过程,直到模型收敛或达到预定的训练轮数。

这一流程确保了模型的协同训练,同时最大限度地保护了各参与方的数据隐私。

联邦学习的系统架构

联邦学习的系统结构通常由以下三类节点构成:

1️⃣ 中央协调节点(Server)

- 负责下发初始模型

- 收集来自各客户端的模型更新

- 执行模型聚合算法(如加权平均)

- 推送更新后的全局模型

2️⃣ 边缘客户端(Clients)

- 本地保存数据(如智能手机、医院数据库、银行终端)

- 进行本地训练

- 上传模型权重或梯度

3️⃣ 安全/中间代理(可选)

- 提供参数加密、认证、匿名化处理

- 在多方部署系统中常用于防止泄露客户端身份或模型参数内容

📌 联邦学习的设计目标之一,是“兼容异构设备”,因此架构需支持:

- 不同网络延迟

- 计算能力差异

- 客户端掉线重连机制

数据隐私保护机制

联邦学习并不天然“安全”,它依然面临被攻击的风险,例如通过模型更新推理原始数据(推理攻击)。因此,必须结合隐私增强技术。

以下是三种常见的保护手段:

🔐 1. 差分隐私(Differential Privacy, DP)

通过向模型梯度或参数中加入“噪声”,避免通过模型恢复原始数据。

| 优势 | 挑战 |

|---|---|

| 数学上有明确隐私保障 | 影响模型收敛精度,需要调节噪声强度 |

🔐 2. 安全多方计算(Secure Multi-Party Computation, SMPC)

参与各方在不泄露自己私有数据的前提下完成联合计算,例如模型聚合。常见方法有 Shamir Secret Sharing。

| 优势 | 挑战 |

|---|---|

| 模型更新过程加密,防止中间人攻击 | 通信开销大,实时性差,适合高安全场景 |

🔐 3. 同态加密(Homomorphic Encryption)

对模型参数加密后仍可执行数学操作,无需解密即能完成聚合。

| 优势 | 挑战 |

|---|---|

| 极高的隐私保障 | 算力消耗大,训练时间显著提升,暂不适合轻端设备 |

📌 组合方案(例如:FedAvg + 差分隐私 + SMPC)目前是工业级部署中的主流选择,兼顾性能与安全性。

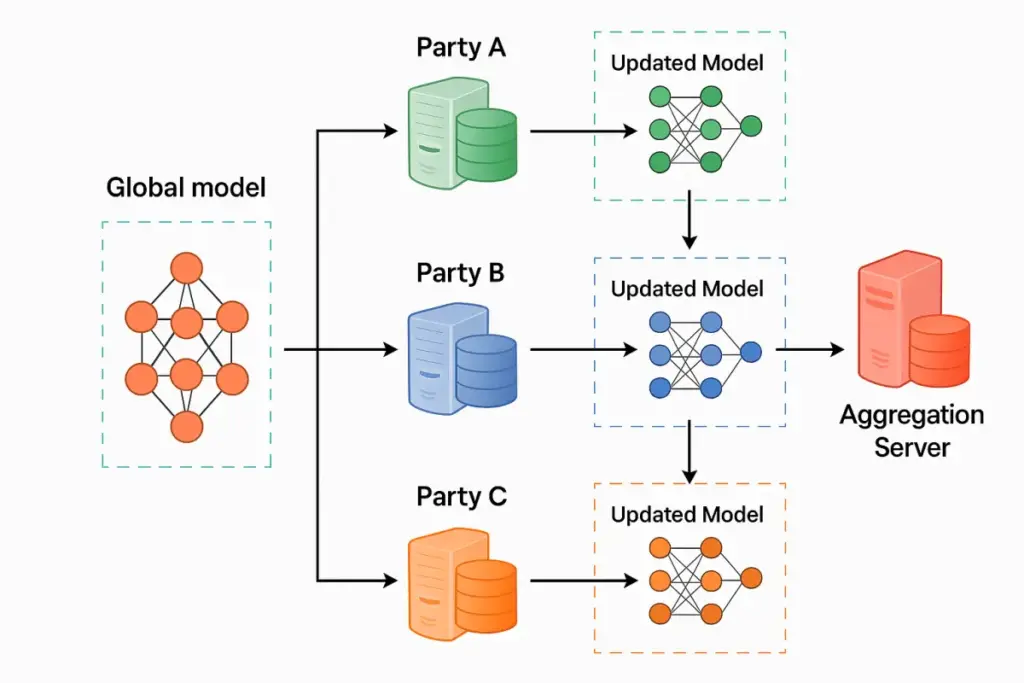

二、联邦学习的基本原理与系统架构

2.1 定义

联邦学习是一种去中心化机器学习框架,它允许多个数据持有方在不共享原始数据的前提下协同训练模型。其核心思想是:

将模型送到数据旁边训练,而不是将数据上传给模型。

因此,数据始终留在本地,只有模型的更新(参数、梯度等)被聚合形成全局模型。

2.2 标准训练流程

一个典型的联邦学习训练过程包含以下步骤:

1. 服务器初始化全局模型

2. 选定一批客户端参与训练

3. 将模型分发给客户端

4. 客户端使用本地数据训练模型若干轮

5. 客户端上传更新后的模型参数

6. 服务器聚合所有客户端参数,更新全局模型

7. 重复上述过程,直到模型收敛

📊 Mermaid 流程图表示如下:

sequenceDiagram participant Server participant Client1 participant Client2 participant Client3 Server->>Client1: 分发初始模型 Server->>Client2: 分发初始模型 Server->>Client3: 分发初始模型 Client1-->>Server: 上传本地训练模型 Client2-->>Server: 上传本地训练模型 Client3-->>Server: 上传本地训练模型 Server->>All: 聚合生成新模型

2.3 优势总结

| 优势 | 描述 |

|---|---|

| 隐私保护 | 不传输数据,天然满足合规 |

| 数据可用性高 | “数据不动,模型移动”适配实际场景 |

| 可扩展性强 | 易于部署到数万级别设备 |

| 支持异构设备 | 可在移动端、边缘、服务器间混合部署 |

2.4 常见联邦学习框架推荐

| 框架 | 开发者 | 特点 |

|---|---|---|

| TensorFlow Federated | 高度集成 TensorFlow,适合研究场景 | |

| PySyft | OpenMined | 支持 DP、SMPC,适合实验室和教育场景 |

| FATE | 微众银行 | 工业级联邦学习平台,支持多种模式,适合金融场景 |

| Flower | Open source | 模块化设计,支持 PyTorch/TensorFlow,适合快速实验 |

三、实战案例:使用 Flower 对 Whisper 模型进行联邦微调

3.1 案例背景

Whisper 是 OpenAI 推出的多语种自动语音识别(ASR)大模型,在语音转录、翻译等任务中表现出色。但其部署到企业内部时面临挑战:

- 各单位拥有不同语音数据(方言、口音、行业术语)

- 数据隐私敏感,无法统一集中训练

因此非常适合采用联邦学习进行跨机构语音识别微调,以提升本地适应能力。

3.2 Flower 框架简介

Flower 是一个通用、模块化、易上手的联邦学习框架,兼容 PyTorch、TensorFlow、JAX 等主流训练平台。其核心优势:

- ✅ 支持横向联邦学习

- ✅ 易于自定义训练逻辑与聚合策略

- ✅ 支持客户端模拟、本地多实例调试

- ✅ 可集成差分隐私、加密机制

Flower 支持的框架一览

| 深度学习框架 | 支持情况 |

|---|---|

| PyTorch | ✅ 完整支持 |

| TensorFlow / Keras | ✅ 支持 |

| JAX / NumPy | ✅ 支持 |

| Scikit-learn | ✅ 支持轻量级模型训练 |

| Hugging Face Transformers | ✅ 可通过 PyTorch 集成 |

3.3 Whisper 联邦训练项目结构

📁 whisper-federated-finetuning/

├── client/

│ ├── client.py # Flower 客户端逻辑封装

│ └── trainer.py # 模型训练函数

├── server/

│ └── server.py # 启动 Flower 服务器 + 策略配置

├── dataset/

│ └── utils.py # 数据处理器(加载音频/标签)

└── requirements.txt3.4 关键代码片段(客户端)

class WhisperClient(fl.client.NumPyClient):

def get_parameters(self, config):

return get_model_weights(model)

def fit(self, parameters, config):

set_model_weights(model, parameters)

train(model, local_loader)

return get_model_weights(model), len(local_data), {}

def evaluate(self, parameters, config):

set_model_weights(model, parameters)

loss = evaluate(model, test_loader)

return float(loss), len(test_loader.dataset), {}📌 说明:

get_parameters()返回模型当前参数(初次为全局模型)fit()为本地训练阶段,使用本地音频数据进行微调evaluate()在客户端进行模型评估并返回损失值

3.5 聚合服务器设置

服务器端的聚合控制逻辑

Flower 提供了灵活的策略配置机制,可以自定义聚合方式、客户端采样比例、训练轮数等。

strategy = fl.server.strategy.FedAvg(

fraction_fit=0.5,

min_fit_clients=3,

min_available_clients=5,

on_fit_config_fn=load_training_config

)

fl.server.start_server(

server_address="0.0.0.0:8080",

config=fl.server.ServerConfig(num_rounds=10),

strategy=strategy,

)📌 说明:

- 使用的是 FedAvg 聚合策略(最经典的联邦平均算法)

- 每轮训练会从注册客户端中抽取部分进行训练(可调节比例)

- 最终生成的全局模型将在多轮聚合后持续优化

四、关键机制与优化策略:构建高效 FL 系统

4.1 聚合算法深入剖析

虽然 FedAvg 是联邦学习的标准聚合策略,但在真实应用中,我们可能会用如下扩展版本:

| 策略 | 原理 | 适用情境 |

|---|---|---|

| FedAvgM | 引入动量项,改善震荡 | 非凸优化问题 |

| FedProx | 加 L2 正则防止局部训练偏移 | 非 IID 且更新发散 |

| FedYogi / FedAdam | 模仿梯度优化器 | 深度模型优化困难时 |

| FedBN | 每个客户端保留自己的 BatchNorm | 图像类任务非 IID |

📌 Flower 中均可通过重写 strategy.aggregate_fit() 接口实现。

4.2 异步通信与容错机制

现实场景中,客户端存在:

- ✖️ 离线/波动(IoT 网络不稳)

- ✖️ 时延差异大(高性能 vs 低功耗设备)

解决方案:

- 使用 FedAsync 或 Staleness-aware Aggregation 策略

- 对每轮选择加入超时设定与

min_available_clients参数 - 将响应缓慢客户端延后处理(Weighted Debias)

4.3 模型个性化(Personalization)

在联邦学习中,部分客户端希望在共享主干模型的同时,定制部分私有能力。例如:

- 保留特定口音适配(语音任务)

- 微调金融/医疗中的特定领域模型层

策略:

- 冻结部分层(共享),开放尾部(私有)

- 使用 Meta Learning 方法(如 pFedMe、FedPer)

Flower 允许在客户端内分别定义参数选择:

def get_model_weights(model):

return [param for name, param in model.named_parameters() if "head" not in name]五、进阶特性与策略优化:如何让联邦学习更实用?

虽然 Flower 默认提供了经典的 FedAvg 策略,但实际部署中,不同场景往往需要更灵活的调控策略与优化技术,以应对真实世界中“非独立同分布(Non-IID)”、“数据量差异大”、“训练不稳定”等问题。

5.1 异构类型分类

| 类型 | 描述 | 示例 |

|---|---|---|

| 标签分布偏移 | 不同客户端拥有不同类别样本 | 医院 A 主要处理老人,B 是儿童病人 |

| 特征偏移 | 相同标签数据在不同客户端表现不同 | 不同麦克风采集的语音特征差异 |

| 样本数量不均 | 客户端数据量悬殊 | A 有上万样本,B 仅百条数据 |

5.2 技术应对策略

| 策略 | 核心思路 | 应用框架支持 |

|---|---|---|

| 数据增强 | 为低样本客户端生成合成样本 | Flower 自定义数据加载器 |

| 正则约束 | 客户端训练时添加 L2 正则项(FedProx) | Flower/FATE |

| 客户端加权 | 小样本客户端减少影响力(按样本数加权) | 默认聚合策略已支持 |

| 元学习方法 | 模型学习如何自我调整结构(如 pFedMe) | 自定义客户端逻辑 |

| 模型分层定制 | 共享主干,定制上层 | 可冻结部分模型层参数实现 |

5.3 高级特性与策略

✅ 个性化联邦学习(Federated Personalization)

在某些应用中,客户端希望拥有“部分共享 + 部分定制”的模型结构,例如:

- 通用部分用于语音识别基础能力

- 私有部分微调以适应某一方的口音或术语

📌 Flower 支持通过定义 fit() 接口,自定义模型层冻结/训练策略,实现“共享主干 + 本地定制”架构。

✅ 差分隐私(Differential Privacy)

联邦学习虽然不传输原始数据,但在梯度参数中仍可能包含敏感信息。

🎯 Flower 可配合 PySyft、Opacus 等差分隐私库,在客户端训练中加入梯度裁剪 + 噪声注入:

from opacus import PrivacyEngine

model = ...

privacy_engine = PrivacyEngine(model, batch_size=64, sample_size=1000, alphas=[10], noise_multiplier=1.0, max_grad_norm=1.2)

privacy_engine.attach(optimizer)📌 这样即使参数被截获,也无法反推出原始数据。

✅ 加密通信(Secure Aggregation)

在高安全性场景(如医疗、政务)中,还可启用联邦学习中的安全聚合协议(Secure Aggregation):

- 模型参数在客户端用同态加密加密后上传

- 服务器只能对加密参数做聚合操作

- 任何单个参与方都无法看到其他人的梯度细节

Flower 支持通过自定义策略接口集成第三方加密库,如 TenSEAL、PySyft。

✅ 不平衡客户端支持(异步优化)

现实中各客户端的计算资源与数据量往往不均衡,出现:

- 部分客户端参与频率低

- 有些设备训练慢、响应超时

解决方案:

- 使用 FedAsync/FedAvgM 等异步策略

- 设置

min_fit_clients,min_eval_clients参数控制训练稳定性 - 启用

client_resources限定每个客户端所需 CPU/GPU

5.4 部署架构建议

📊 推荐架构图:

graph TD DevOps[开发运维] --> API[训练控制接口] API --> FLServer[Flower Server] FLServer --> C1[Client: 医院 A] FLServer --> C2[Client: 医院 B] FLServer --> C3[Client: 大学 C] FLServer --> Monitor[监控模块]

工程建议清单:

- 使用 Docker Compose / Kubernetes 编排训练任务

- 集成 MLflow / WandB 实现指标追踪与版本管理

- 配置 TLS + 认证机制,防止恶意客户端注入

- 加入 评估队列,按区域 / 机构维度评估全局模型泛化能力

六、总结与开发者建议清单

联邦学习作为连接 AI 与隐私边界的重要技术路线,其应用已不再是学术幻想,而是逐步融入工业与商业落地流程。

面向开发者的实践建议:

| 场景 | 推荐实践 |

|---|---|

| 快速原型验证 | 使用 Flower 本地模拟环境 |

| 跨平台设备训练 | 结合 PyTorch Lightning + Flower |

| 多语言任务 | Whisper + HuggingFace + FL |

| 工业级部署 | 使用 FATE,配置 SMPC/DP 模块 |

| 高异构性场景 | 考虑 pFedMe / FedBN / 局部冻结层方案 |

📎 延伸阅读 & 工具推荐:

- 🌐 Flower 官网与文档

- 📘 Whisper 模型联邦学习微调示例:On-device Federated Finetuning for Speech Classification - Flower Examples 1.18.0

- 🧱 PySyft:GitHub - OpenMined/PySyft: Perform data science on data that remains in someone else's server

- 🔐 Opacus(PyTorch DP 工具):[GitHub - pytorch/opacus: Training PyTorch models with differential privacy

典型应用介绍