- Mark Ren

-

-

-

在数据与智能驱动创新的时代,边缘计算(Edge Computing) 对 实时 AI(Real-Time AI) 应用的推动作用至关重要。传统的云计算架构在过去十年中为数据处理和 AI 训练带来了重大突破,但随着设备、传感器数量的激增以及复杂 AI 任务的增长,集中式计算的局限性逐渐显现:高延迟、带宽受限、数据隐私问题等因素 限制了真正实时 AI 系统的潜力。

边缘计算 的出现正是为了弥补这些不足。通过在数据生成的源头(如摄像头、传感器、工业设备)附近部署计算资源,边缘计算显著减少数据往返云端的时间,从而降低整体延迟。据 Gartner 预测,到 2025 年,超过 75% 的企业数据将由边缘设备生成并进行处理,可见边缘计算与 AI 结合的重要性。

本博客将深入探讨边缘计算对实时 AI 应用的影响,包括边缘计算的核心驱动因素、行业应用、技术架构、挑战及未来趋势。无论你是正在探索新硬件解决方案的初创公司,还是希望优化关键 AI 业务的企业,理解 边缘计算如何提升 AI 的实时能力,将为你的战略布局带来深远影响。

边缘计算与实时AI 的定义

什么是边缘计算?

边缘计算(Edge Computing) 是一种计算架构,它将计算和数据存储从集中式云端移动到更接近数据源的设备或服务器。与传统的 云计算 依赖远程数据中心不同,边缘计算使用 本地计算资源(如微型数据中心、边缘服务器、智能设备) 处理数据,从而减少网络延迟和带宽消耗。

边缘计算的核心特点包括:

- 数据源附近处理:减少数据传输时间,提高处理效率。

- 低延迟:避免数据往返云端造成的延迟,提高响应速度。

- 上下文智能:本地设备可根据特定环境自适应调整计算方式。

- 高可靠性:即使网络中断,本地系统仍可继续运行 AI 任务。

什么是实时AI?

实时 AI(Real-Time AI) 指能够在毫秒级时间内完成推理或决策的 AI 系统。相比批量处理或延迟分析,实时 AI 关注的是超低延迟的计算能力,适用于自动驾驶、机器人控制、医疗监测等场景。

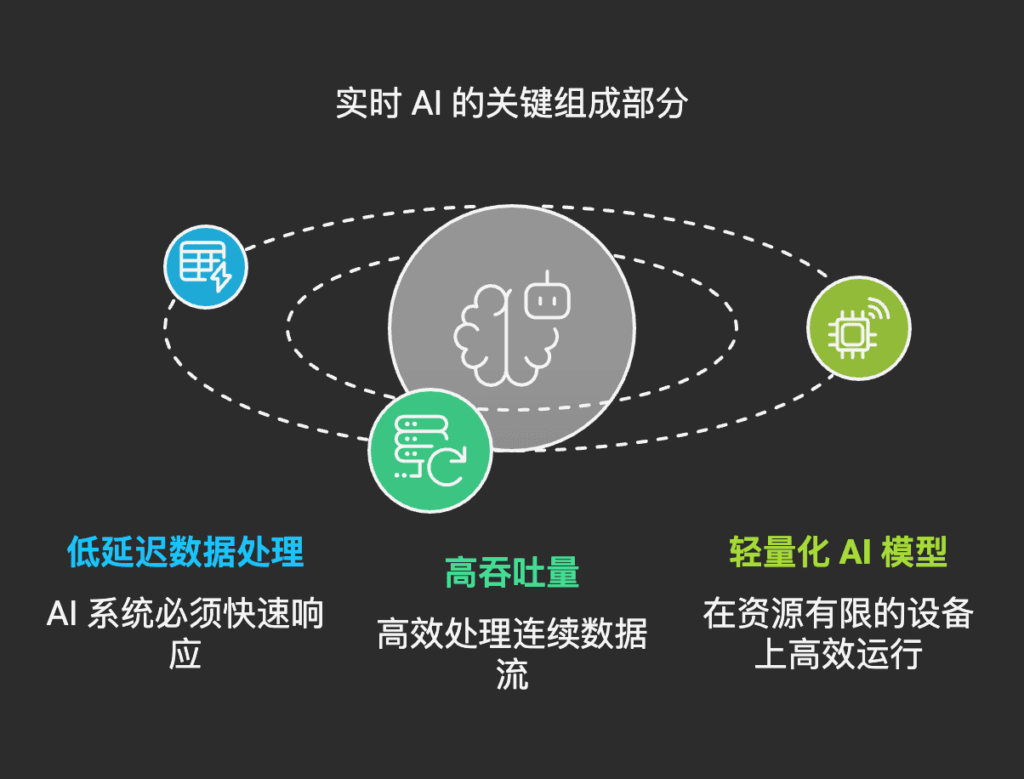

实时 AI 的核心要求:

- 低延迟数据处理:AI 系统必须能在极短时间内做出响应。

- 高吞吐量:能够高效处理连续数据流(如摄像头视频、传感器数据)。

- 轻量化 AI 模型:在计算受限的设备上运行高效 AI 模型。

当边缘计算和实时 AI 结合,便形成了 “边缘 AI”,即在本地执行 AI 推理,减少对云端的依赖,使 AI 更快、更安全、更稳定。

边缘计算为何对实时AI 重要

- 极低延迟 实时 AI 任务无法忍受云计算引入的高延迟。例如,在自动驾驶场景中,AI 需要在 10 毫秒内 处理雷达和摄像头数据,以避免碰撞。边缘计算让 AI 直接在车载计算设备上运行,从而实现毫秒级决策。

- 带宽与网络优化 摄像头、传感器每天产生 PB 级数据,若全部上传至云端,将导致网络带宽过载。边缘计算可在本地先处理数据,仅将必要的分析结果发送至云端,减少带宽占用和成本。

- 数据隐私与安全 医疗、金融、安防等行业对数据安全要求严格,数据未经本地处理就传输至云端,存在较大隐私泄露风险。边缘计算让敏感数据不出本地,从源头提高安全性。

- 稳定性与业务连续性 许多 AI 应用要求 24/7 持续运行,如智能监控、工业自动化。如果 AI 计算仅依赖云端,断网时系统将瘫痪。边缘计算确保即使网络中断,关键 AI 任务仍能正常运行。

支撑边缘 AI 的关键技术

边缘计算如何实现实时 AI?以下是几个核心技术:

- 专用 AI 硬件(GPU、NPU、FPGA)

- GPU(图形处理器):高效执行 AI 推理,如 NVIDIA Jetson。

- NPU(神经网络处理单元):专门优化 AI 计算,如华为 Ascend、Google Coral TPU。

- FPGA(可编程门阵列):灵活、低功耗,适合特定 AI 任务。

- 轻量化 AI 模型(模型压缩、TinyML)

- 模型剪枝:移除冗余神经元,加速计算。

- 量化:降低模型计算精度,减少功耗。

- TinyML:适用于微控制器的极低功耗 AI 计算。

- 边缘 AI 框架

- TensorFlow Lite:Google 轻量级 AI 推理库。

- ONNX Runtime:支持多种 AI 硬件的跨平台推理引擎。

- PyTorch Mobile:适用于移动和边缘设备的 PyTorch 版本。

- 5G 与新一代网络

- 5G 的超低延迟特性(1ms 内)为边缘 AI 提供更快的云-边协同能力。

行业应用与案例分析

边缘计算与实时 AI 的结合已经在多个行业中落地应用,并显著提升了业务效率与智能化水平。以下是一些典型行业及案例:

1. 自动驾驶与智能交通

场景:自动驾驶车辆需要在毫秒级时间内完成环境感知、路径规划和决策,如紧急避障、行人检测等。

挑战:如果依赖云端 AI 计算,数据往返的网络延迟可能超过 100 毫秒,影响驾驶安全。

解决方案:

- 在车载计算单元(如 NVIDIA Drive、Mobileye 方案)中集成 AI 处理芯片(GPU/NPU),在本地执行计算机视觉任务,如 目标检测、交通信号识别 等。

- 5G 低延迟通信 + 边缘计算服务器,帮助车联网系统实现实时交通预测和道路优化。

案例: - 特斯拉 FSD(Full Self Driving)系统 依赖强大的边缘 AI 芯片(Dojo 训练系统)在车辆本地进行深度学习推理,从而提升自动驾驶能力。

- Waymo 无人驾驶汽车 使用高性能边缘计算节点实时分析 LiDAR 数据,以实现安全驾驶。

2. 工业 4.0 与智能制造

场景:现代工厂中的传感器和摄像头需要对生产线进行质量检测、设备预测性维护,并实时优化生产调度。

挑战:传统云计算架构在高实时性要求的工厂车间容易受限于网络延迟、带宽占用问题。

解决方案:

- 在生产设备端部署 AI 视觉检测系统,实时检测缺陷产品,并剔除不良品。

- 边缘服务器 结合 AI 算法监测设备振动、温度、电流等参数,提前预测设备故障,减少停机损失。

案例: - 西门子 通过 Edge AI 在生产线上检测产品质量,减少 30% 返工成本。

- 宝马(BMW)智能工厂 部署 AI 视觉检测系统,实现生产全自动化,提高了生产效率。

3. 医疗与远程健康监测

场景:医院的 ICU 病房、远程医疗监护系统需要对患者生理信号(心率、血氧、呼吸频率)进行 24/7 实时监测。

挑战:如果数据传输到云端再进行处理,可能因网络不稳定导致延迟,甚至影响患者救治。

解决方案:

- AI 边缘设备(如可穿戴医疗监测设备)在本地处理生理数据,并在异常情况发生时即时报警。

- 医院服务器使用 本地 AI 模型 进行影像诊断分析,提高医生的诊断速度和准确性。

案例: - Philips HealthSuite Edge AI 通过智能传感器实现患者数据本地处理,提高医疗响应速度。

- GE Healthcare 在 MRI 扫描设备中内置 AI 分析能力,使医生在几分钟内得到精准诊断结果。

4. 零售与智慧商店

场景:无人零售商店、智能结算系统需要 AI 实时检测顾客行为,完成自动结账与库存管理。

挑战:传统云端 AI 计算可能导致识别速度慢,影响购物体验。

解决方案:

- 边缘摄像头 + 计算机视觉 AI 识别顾客购买商品,并自动完成结算。

- 商店内部署 库存智能检测系统,在本地进行 AI 识别,减少缺货损失。

案例: - 亚马逊 Go 无人商店 采用 Edge AI 进行商品识别和自动结算,实现“拿了就走”的购物体验。

- 沃尔玛 使用 AI 监控货架库存,优化供应链管理,提高运营效率。

技术架构与数据流

实时 AI 在边缘计算架构中的典型数据流如下:

- 数据采集:摄像头、传感器、麦克风等设备持续收集环境数据。

- 边缘计算处理:边缘设备(如智能网关、AI 芯片、边缘服务器)执行 AI 推理,提取关键信息。

- 本地响应:如自动驾驶汽车执行避障、智能制造设备执行质量检测。

- 云端协同:将部分数据上传至云端,进行长期趋势分析或 AI 模型更新。

- 模型优化与下发:云端定期优化 AI 模型,并推送至边缘设备,确保 AI 在本地的持续优化。

flowchart LR A[数据采集层摄像头、传感器] --> B[边缘计算层AI 推理] B --> C[实时决策设备控制] B --> D[云端分析数据存储] D --> E[模型训练优化 AI 模型] E --> B[模型更新部署到边缘]

表格:边缘计算 vs 云计算在实时 AI 任务中的对比

| 对比项 | 边缘计算 | 云计算 |

|---|---|---|

| 延迟 | 毫秒级(1-10ms) | 可能超过 100ms |

| 带宽 | 低(仅传输关键数据) | 高(传输完整数据) |

| 数据安全 | 数据留在本地,安全性高 | 传输过程中可能泄露 |

| 可靠性 | 网络断连仍能运行 | 依赖网络连接 |

| 适用场景 | 实时控制(自动驾驶、智能制造) | 深度学习训练、大数据分析 |

市场研究机构 IDC 预测,到 2026 年全球边缘计算市场规模将超过 2500 亿美元,其中 AI 相关应用占据重要部分。随着企业对实时智能决策的需求增长,边缘 AI 将成为未来产业数字化转型的关键技术。

边缘计算与 AI 结合,为实时应用提供了更低延迟、更高可靠性和更优的隐私保护能力。通过分布式智能计算,企业能够提升 AI 任务的执行效率,并减少对云端的依赖。未来,随着硬件优化、5G 网络和 AI 算法的发展,边缘 AI 将在更多行业落地,为企业创造更大价值。

典型应用介绍