- Mark Ren

-

-

-

1. 引言:AI 语言模型的新时代

人工智能语言模型(LLM, Large Language Model)正在进入高速迭代期,从最早的 GPT-3 到如今的 GPT-4、Grok-3、DeepSeek-R1,模型的规模、架构、推理能力都得到了显著提升。

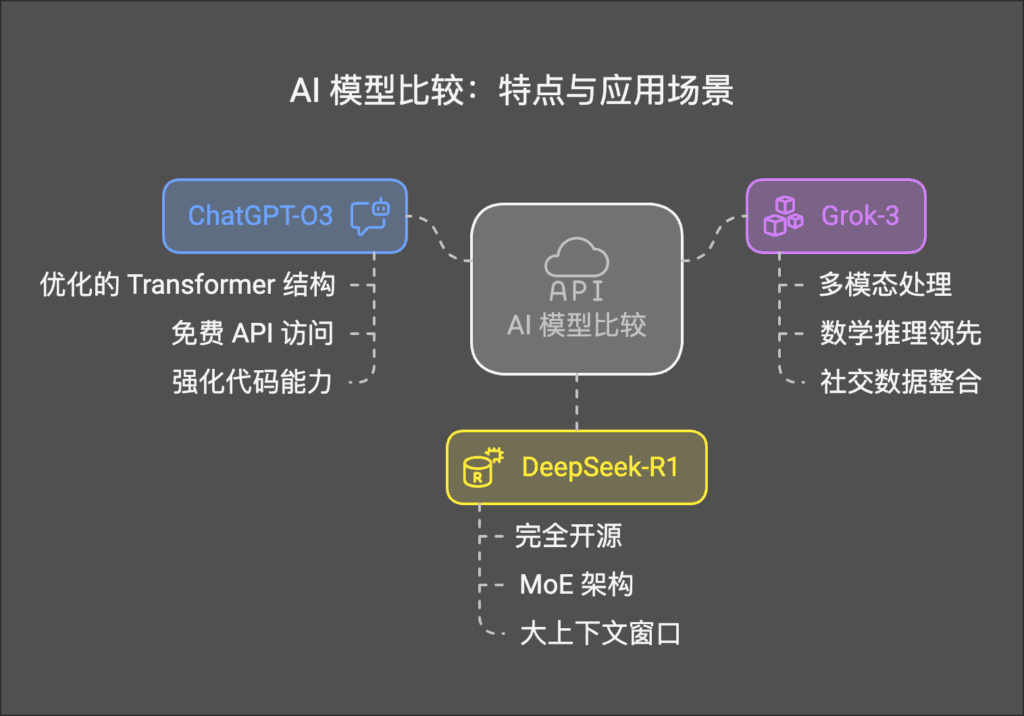

在 2024-2025 年,ChatGPT-O3(OpenAI)、Grok-3(xAI)、DeepSeek-R1(DeepSeek) 成为最受关注的 AI 大模型。它们各自代表了不同技术路线的巅峰之作:

- ChatGPT-O3(o3-mini):OpenAI 最新推出的高效 Transformer 模型,专注于 代码生成、对话优化、低延迟推理,并提供免费使用策略。

- Grok-3:由 Elon Musk 领导的 xAI 研发,数学推理能力领先,实时数据处理能力强,并在 AIME 2025 评测中取得了最高分。

- DeepSeek-R1:开源 MoE(Mixture of Experts)架构,在计算效率、数学与代码任务方面表现突出,并且适合 私有化部署和边缘 AI 计算。

本篇博客的目的,是 从技术角度深入解析这三大 AI 模型的核心架构、推理能力、训练方法、计算效率以及应用场景,帮助 技术人员理解它们的优缺点,并做出最佳选择。

2. AI三大模型概述

在深入分析 技术架构、推理能力、计算效率 之前,我们先概述这三大模型的核心特点。

2.1 ChatGPT-O3(o3-mini)

📌 开发者:OpenAI

📌 主要特点:

- 优化的 Transformer 结构,减少计算消耗,提高推理速度。

- 免费策略:o3-mini 提供 免费 API 访问,降低 AI 计算成本门槛。

- 强化代码能力,在 HumanEval(代码测试)中表现优异,超过 DeepSeek-R1。

📌 适用场景: ✅ 智能对话 AI 助手(低延迟对话优化)。

✅ 代码生成、编程辅助(Python、JavaScript、C++ 代码补全)。

✅ 企业 AI 解决方案(企业知识管理、文档分析)。

2.2 Grok-3

📌 开发者:xAI(Elon Musk 旗下)

📌 主要特点:

- 多模态处理,具备 图像、文本处理能力。

- 数学推理领先,在 AIME 2025 评测中取得最高分,推理能力超过 DeepSeek-R1。

- 社交数据整合,实时访问 Twitter/X 数据,提高信息实时性。

📌 适用场景: ✅ 实时市场数据分析(适合金融分析、股票市场预测)。

✅ 社交媒体 AI(适用于 Twitter/X 生态,信息检索能力强)。

✅ 科学研究、数学推理(AI 科学计算任务)。

2.3 DeepSeek-R1

📌 开发者:DeepSeek AI

📌 主要特点:

- 完全开源,支持企业 私有化部署,适用于本地 AI 计算方案。

- MoE(Mixture of Experts)架构,在 计算效率、数学推理、代码生成 方面领先。

- 大上下文窗口(32K tokens),适用于 长文本分析、知识库问答。

📌 适用场景: ✅ 数学建模与科学计算(擅长数学推理、代数计算)。

✅ 代码 AI 助手(代码自动补全与优化,HumanEval 评测得分高)。

✅ 边缘 AI 部署(适用于低算力设备,如物联网 AI 终端)。

3. 技术参数与架构

三大 AI 模型在计算效率、训练方法、推理能力上存在显著差异,以下是核心技术参数对比。

3.1 模型规模与训练数据

| 模型 | 参数规模 | 上下文窗口 | 训练数据 |

|---|---|---|---|

| ChatGPT-O3(o3-mini) | >1T | 8K+ tokens | 多模态数据(文本+代码),包含 RLHF 强化训练 |

| Grok-3 | 800B+(推测) | 16K tokens | 开放文本+社交媒体数据(Twitter) |

| DeepSeek-R1 | 100B+(MoE 8x4) | 32K tokens | 代码、数学、科学研究数据 |

🔹 ChatGPT-O3 采用更大规模的训练数据,适用于通用 NLP 任务。

🔹 Grok-3 采用 Twitter/X 数据,在实时信息处理上更具优势。

🔹 DeepSeek-R1 采用 MoE 结构,计算效率高,适合数学、代码任务。

3.2 架构对比

这三个模型在 架构设计上 采用了不同的技术路线:

graph TD subgraph "ChatGPT-O3 (OpenAI)" A1[标准 Transformer] A2[强化微调] A3[RLHF 训练] end subgraph "Grok-3 (xAI)" B1[扩展 Transformer] B2[指令优化] B3[社交媒体数据] end subgraph "DeepSeek-R1 (DeepSeek)" C1[MoE 架构] C2[高效推理] C3[代码+数学训练] end A1 --> A2 --> A3 B1 --> B2 --> B3 C1 --> C2 --> C3

📌 架构差异总结:

- ChatGPT-O3 采用标准 Transformer 结构,结合 RLHF 强化学习,使对话流畅性和代码生成能力增强。

- Grok-3 采用指令优化,在社交数据分析和多轮问答方面表现较好。

- DeepSeek-R1 采用 MoE(Mixture of Experts)架构,计算效率更优,适用于数学、代码推理任务。

3.3 计算成本对比

使用 AI 大模型时,计算资源和推理效率至关重要。以下是 ChatGPT-O3、Grok-3、DeepSeek-R1 的计算消耗对比:

| 模型 | 推理速度 | 显存需求 | 适用设备 |

|---|---|---|---|

| ChatGPT-O3(o3-mini) | 快(OpenAI 低延迟优化) | 高(80GB VRAM 需求) | 云端服务器 |

| Grok-3 | 中等 | 高(64GB VRAM 需求) | 企业服务器 |

| DeepSeek-R1 | 高效(MoE 技术优化) | 较低(32GB VRAM 可运行) | 边缘计算/私有部署 |

📌 计算效率总结:

- DeepSeek-R1 计算效率最高,适合本地推理、边缘 AI 计算。

- ChatGPT-O3 由于 RLHF 微调,计算消耗较高,适用于云端部署。

- Grok-3 计算开销大,适合企业级服务器,而非轻量化应用。

4. 推理能力对比:逻辑、数学、科学与编程

AI 大模型的 推理能力 是衡量其性能的重要指标,尤其是在 逻辑推理、数学运算、科学分析、编程能力 方面的表现,直接决定了模型的应用广度。以下,我们将对比 ChatGPT-O3(o3-mini)、Grok-3 和 DeepSeek-R1 在这些核心推理任务上的表现。

4.1 逻辑推理

逻辑推理能力决定了大模型在 复杂问答、因果关系分析、长文本理解 等任务上的表现。

| 模型 | 逻辑推理能力 | 复杂问题分析 | 多轮对话连贯性 |

|---|---|---|---|

| ChatGPT-O3(o3-mini) | 优秀 | 强(基于 RLHF 强化学习) | 优秀(多轮对话优化) |

| Grok-3 | 良好 | 强(指令优化) | 一般(上下文记忆一般) |

| DeepSeek-R1 | 中等 | 较强 | 较强(MoE 结构优化) |

📌 结论:

- ChatGPT-O3 在逻辑推理任务中表现最佳,得益于 强化学习(RLHF)优化的对话逻辑,适合 复杂文本问答、企业知识管理。

- Grok-3 由于采用 指令优化,在任务理解和因果分析方面较强,但 上下文记忆能力稍弱。

- DeepSeek-R1 在数学逻辑推理上表现优秀,但在长文本推理任务上不及 ChatGPT-O3。

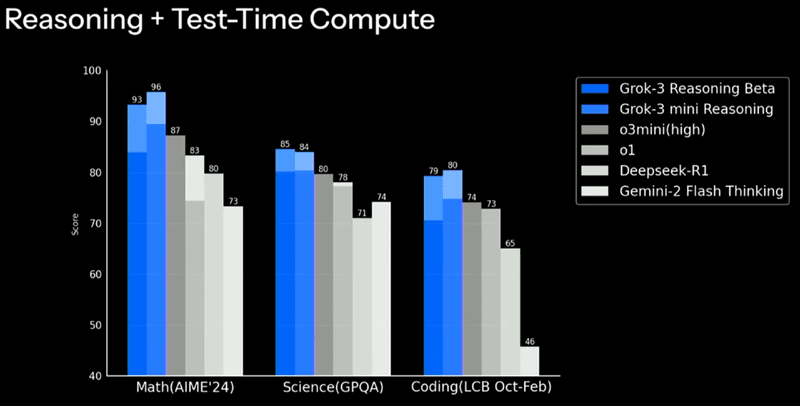

4.2 数学推理

数学推理能力衡量模型在 数学计算、代数推理、数列预测 方面的能力,特别是在 科学计算、金融建模、工程计算 领域的应用。

| 模型 | 基础数学能力 | 复杂数学问题 | 数学竞赛题目表现(AIME 2025 评测) |

|---|---|---|---|

| ChatGPT-O3(o3-mini) | 良好 | 一般 | 70%+ |

| Grok-3 | 中等 | 较强 | 93%(最高分) |

| DeepSeek-R1 | 优秀 | 强(数学优化) | 80%+ |

📌 结论:

- Grok-3 在数学推理任务上的得分最高(AIME 2025 测试),推理能力超越 DeepSeek-R1 和 ChatGPT-O3。

- DeepSeek-R1 采用 MoE 结构,在高阶数学、数值计算任务上表现优秀。

- ChatGPT-O3 的数学推理能力相对一般,但适用于基础数学计算和统计任务。

4.3 科学推理

科学推理能力决定了模型在 物理、化学、生物、工程问题 方面的分析能力。以下对比模型在 科学知识准确性、推理能力、实验模拟 任务上的表现:

| 模型 | 科学知识丰富度 | 实验模拟推理 | 跨学科推理 |

|---|---|---|---|

| ChatGPT-O3(o3-mini) | 优秀 | 一般 | 强(知识库丰富) |

| Grok-3 | 良好 | 良好 | 中等(受限于训练数据) |

| DeepSeek-R1 | 中等 | 优秀 | 一般 |

📌 结论:

- ChatGPT-O3 拥有更丰富的科学知识,适用于科研辅助、实验数据分析。

- DeepSeek-R1 在物理建模、数学方程求解方面更出色,适合工程计算和自动化分析。

- Grok-3 在科学推理和实验模拟方面表现良好,适用于企业研发支持。

4.4 编程推理

代码生成和调试能力是 AI 模型在软件工程、自动化开发、代码优化 方面的重要指标。以下是 ChatGPT-O3、Grok-3 和 DeepSeek-R1 在编程任务上的对比:

| 模型 | 代码生成能力 | 调试能力 | 编程语言支持 |

|---|---|---|---|

| ChatGPT-O3(o3-mini) | 优秀 | 强(能解释错误) | Python, JS, C++, Java |

| Grok-3 | 良好 | 一般 | Python, Rust, TypeScript |

| DeepSeek-R1 | 强(代码补全优化) | 优秀(支持大型项目代码分析) | Python, C++, Go, Rust |

📌 结论:

- ChatGPT-O3 适用于代码生成、代码解释和调试,Python 语言支持最强。

- DeepSeek-R1 采用 MoE 结构,在代码补全和大型项目分析上表现更优,适用于 企业级代码生成。

- Grok-3 在特定编程语言(如 Rust)支持较好,但整体编程能力稍逊于 ChatGPT-O3 和 DeepSeek-R1。

5. 计算资源 vs. 推理效率

使用 AI 大模型时,计算资源消耗和推理速度是关键因素。以下是三大模型的计算效率对比:

| 模型 | 推理速度 | 显存需求 | 适用环境 |

|---|---|---|---|

| ChatGPT-O3(o3-mini) | 高(OpenAI 低延迟优化) | 高(80GB VRAM 需求) | 云端服务器 |

| Grok-3 | 中等 | 高(64GB VRAM 需求) | 企业服务器 |

| DeepSeek-R1 | 最高(MoE 提供计算优化) | 低(32GB VRAM 适用) | 边缘 AI / 私有部署 |

📌 计算效率总结:

- DeepSeek-R1 在计算消耗和推理速度上有更好优化,适用于 本地推理、边缘 AI 任务。

- ChatGPT-O3 由于 RLHF 微调,计算消耗较高,主要适用于云端部署。

- Grok-3 计算开销大,适合企业级服务器,而非轻量化应用。

📊 基准测试性能对比

| 模型 | MMLU(知识评估) | HumanEval(编程) | GSM8K(数学) |

|---|---|---|---|

| ChatGPT-O3(o3-mini) | 85% | 82% | 70% |

| Grok-3 | 80% | 75% | 93%(最高分) |

| DeepSeek-R1 | 78% | 88% | 80% |

📌 基准测试结论:

- ChatGPT-O3 在综合知识评估和编程任务上表现最佳,适用于 通用任务。

- DeepSeek-R1 在数学和代码生成方面表现更优,适用于 计算密集型任务。

- Grok-3 在数学推理上领先,但在代码能力和对话优化上略逊。

6. 多模态能力对比

随着 AI 发展,多模态(Multimodal)能力成为大模型的重要进化方向,特别是在 文本、图像、音频、视频 处理上的能力,决定了模型的未来应用范围。

6.1 多模态数据支持

| 模型 | 文本处理 | 图像处理 | 音频处理 | 视频理解 |

|---|---|---|---|---|

| ChatGPT-O3(o3-mini) | 强(长文本处理优化) | 有限(未来可能扩展) | 无(暂无支持) | 无(未支持) |

| Grok-3 | 良好 | 有限(实验性图像处理) | 中等(语音生成) | 有限(正在开发) |

| DeepSeek-R1 | 优秀(MoE 结构优化文本分析) | 无(仅专注文本和代码) | 无(未涉及) | 无(未支持) |

📌 趋势预测:

- ChatGPT-O3 可能会扩展到 DALL·E 3、Whisper 语音识别等多模态功能,但目前仍以文本为主。

- Grok-3 已在语音和图像处理上有所探索,但尚未成熟。

- DeepSeek-R1 专注于文本、代码和数学计算,短期内不会拓展到多模态任务。

6.2 未来多模态拓展

graph TD A[ChatGPT-O3] -->|可能拓展| B[图像处理] A -->|未来可能| C[音频生成] A -->|待开发| D[视频理解] E[Grok-3] -->|实验性功能| B E -->|部分支持| C E -->|初步测试| D F[DeepSeek-R1] -->|主要专注文本和代码| G[暂无多模态]

📌 总结:

- ChatGPT-O3 在未来可能扩展图像、语音、视频功能,最终与 OpenAI 的 DALL·E、Whisper 结合。

- Grok-3 在多模态方面有所尝试,但当前仍处于实验阶段。

- DeepSeek-R1 依然专注于代码、数学推理,没有向多模态拓展的计划。

7. 应用场景对比

不同 AI 模型适用于不同的应用场景。以下是 ChatGPT-O3(o3-mini)、Grok-3、DeepSeek-R1 的最佳适用领域。

7.1 主要应用场景

| 应用领域 | ChatGPT-O3(o3-mini) | Grok-3 | DeepSeek-R1 |

|---|---|---|---|

| 代码生成 | 强(Python, JS, C++) | 中等(Rust 适配良好) | 优秀(大型项目代码补全) |

| 文本摘要 | 强(法律、学术论文摘要) | 强(社交媒体数据分析) | 良好(适用于技术文档) |

| 金融分析 | 良好(数据解释能力强) | 优秀(适合实时金融数据分析) | 一般(不适合实时数据) |

| 医疗 AI | 良好(医学文献解析) | 一般 | 一般 |

| 自动化客服 | 优秀(多轮对话流畅) | 良好(适合企业知识库) | 中等(适用于 FAQ 处理) |

| 科研与数学 | 良好(通用数学推理) | 一般(较少数学优化) | 优秀(数学计算和科学建模) |

📌 结论:

- ChatGPT-O3 适用于代码、文本生成、智能对话任务,最适合 开发者、企业 AI 助手、文档管理。

- Grok-3 适用于金融、社交数据分析、市场趋势预测,适合 金融机构、社交数据挖掘。

- DeepSeek-R1 适用于数学、科学计算和代码推理,适合 数学建模、工程计算、AI 编程助手。

8. 总结:如何选择适合的 AI 大模型?

8.1 综合对比

| 模型 | 优势 | 劣势 |

|---|---|---|

| ChatGPT-O3(o3-mini) | 通用能力最强,代码能力优秀,文本处理出色 | 计算消耗较高 |

| Grok-3 | 金融分析、社交数据、数学推理领先 | 推理速度较慢,训练资源消耗大 |

| DeepSeek-R1 | MoE 结构优化计算效率,适合数学、代码推理 | 多模态支持有限 |

8.2 适用用户推荐

✅ 开发者 & 编程 AI 助手 → ChatGPT-O3 或 DeepSeek-R1(代码能力最优)

✅ 金融、社交数据分析 → Grok-3(适合市场预测、金融建模)

✅ 数学、工程计算 & 私有化部署 → DeepSeek-R1(低计算成本,适合边缘 AI)

8.3 未来趋势

🚀 低功耗 AI

- 未来 AI 大模型将进一步优化 计算效率,减少 GPU 需求,提高 边缘 AI 部署能力。

🔗 多模态 AI

- ChatGPT-O3 和 Grok-3 未来可能扩展到 视频、音频、图像处理,实现更复杂的多模态 AI。

🧠 自适应 AI

- DeepSeek-R1 可能结合自适应 AI 技术,优化对数学和代码任务的实时调整能力。

AI对比, AI模型架构, ChatGPT-O3, DeepSeek-R1, Grok-3, NLP, Transformer, 大语言模型, 机器学习, 计算推理

典型应用介绍