- ZedIoT

-

-

-

在医学影像分析中,胃肠镜检查是检测消化道疾病的重要手段。然而,由于胃肠镜视频数据量大、医生需长时间集中注意力,自动化的病灶识别系统成为了一个研究热点。本文将详细介绍如何通过深度学习技术,对胃肠镜视频流中的炎症和病灶进行标注、训练模型,并实现实时病灶识别的技术方案。

数据收集与标注

1.数据收集

首先需要从医院或研究机构收集大量的胃肠镜视频数据。这些数据应包括各种类型的炎症和病灶,并覆盖不同的患者和检查角度,以提高模型的泛化能力。

2.数据标注

为了训练深度学习模型,必须对胃肠镜视频中的炎症和病灶进行精确的标注。常用的开源标注工具包括:

● LabelImg:支持创建 PascalVOC 和 YOLO 格式的标注文件,适合简单的矩形标注任务。

● LabelMe:支持多种标注类型,包括多边形,适合复杂的标注任务。

● CVAT (Computer Vision Annotation Tool):功能强大,适合大规模数据的标注,支持视频帧的标注。

标注流程

- 导入视频数据:将胃肠镜视频数据导入标注工具。

- 帧提取:从视频中提取帧,可以每秒提取一帧进行标注。

- 标注炎症和病灶:对每个帧中的炎症和病灶进行标注,记录其位置和类别。

- 保存标注文件:将标注结果保存为指定格式文件,供模型训练使用。

数据预处理

1.帧提取

利用 OpenCV 从视频中提取静态帧:

import cv2

def extract_frames(video_path, output_folder, frame_rate=1):

cap = cv2.VideoCapture(video_path)

count = 0

while cap.isOpened():

ret, frame = cap.read()

if not ret:

break

if count % frame_rate == 0:

frame_filename = f"{output_folder}/frame_{count}.jpg"

cv2.imwrite(frame_filename, frame)

count += 1

cap.release()2.数据增强

数据增强是提升模型性能的重要手段。常用方法包括随机旋转、水平和垂直翻转、随机裁剪和颜色抖动。可以使用 TensorFlow 或 PyTorch 提供的数据增强工具,也可以使用 albumentations 等第三方库。

import albumentations as A

from PIL import Image

import numpy as np

def augment_image(image):

transform = A.Compose([

A.HorizontalFlip(p=0.5),

A.RandomBrightnessContrast(p=0.2),

A.Rotate(limit=20, p=0.5)

])

augmented = transform(image=np.array(image))

return Image.fromarray(augmented['image'])模型设计与训练

1.模型选择

根据任务需求选择适合的深度学习模型:

● CNN(卷积神经网络):适合图像分类和特征提取。

● YOLO(You Only Look Once):适合实时目标检测任务,能够在一帧图像中快速检测多个对象。

● Faster R-CNN:在目标检测任务中表现出色,适合精确的病灶检测。

● Mask R-CNN:在目标检测的基础上增加了实例分割功能,适合精确的病灶定位和分割。

2.模型训练

以 YOLO 为例,使用 TensorFlow 进行模型训练:

import tensorflow as tf

from yolov3_tf2.models import YoloV3

from yolov3_tf2.dataset import transform_images, load_tfrecord_dataset

from yolov3_tf2.utils import load_darknet_weights

# 加载数据集

train_dataset = load_tfrecord_dataset('path/to/train.tfrecord', 'path/to/classes.txt')

train_dataset = train_dataset.map(lambda x, y: (transform_images(x, 416), y))

# 加载模型

yolo = YoloV3(classes=NUM_CLASSES)

load_darknet_weights(yolo, 'path/to/yolov3.weights')

# 编译模型

yolo.compile(optimizer=tf.keras.optimizers.Adam(),

loss=[tf.keras.losses.CategoricalCrossentropy(from_logits=True),

tf.keras.losses.BinaryCrossentropy()],

metrics=['accuracy'])

# 训练模型

yolo.fit(train_dataset, epochs=EPOCHS, steps_per_epoch=STEPS_PER_EPOCH)

# 保存模型

yolo.save_weights('path/to/yolov3_weights.h5')3.模型评估与优化

模型训练完成后,需要对其进行评估。常用评估指标包括准确率、召回率和 F1-score。通过调整模型结构、增加数据量以及使用更先进的优化算法,可以进一步提高模型性能。

# 评估模型

eval_dataset = load_tfrecord_dataset('path/to/eval.tfrecord', 'path/to/classes.txt')

eval_dataset = eval_dataset.map(lambda x, y: (transform_images(x, 416), y))

yolo.evaluate(eval_dataset)系统集成与部署

1.实时视频流处理

为了在实际的胃肠镜检查中实现实时病灶识别,需要将训练好的模型集成到视频流处理系统中。可以使用 OpenCV 或 GStreamer 处理实时视频流,并将每一帧传递给模型进行预测。

2.系统架构

一个典型的实时病灶识别系统架构包括以下组件:

● 视频采集模块:负责采集胃肠镜视频流。

● 视频处理模块:负责视频帧的提取和预处理。

● 病灶识别模块:加载训练好的深度学习模型,对每一帧进行病灶识别。

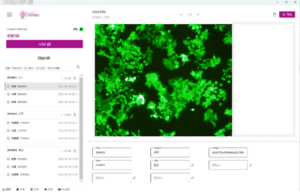

● 结果展示模块:将识别结果实时显示在胃肠镜检查界面上,辅助医生进行诊断。

3.部署

系统部署需要考虑计算资源和响应时间。可以选择在本地服务器或云端部署模型,并利用 GPU 提高计算效率。

以下是一个简单的实时病灶识别示例代码:

import cv2

import tensorflow as tf

from yolov3_tf2.models import YoloV3

from yolov3_tf2.dataset import transform_images

# 加载模型

yolo = YoloV3(classes=NUM_CLASSES)

yolo.load_weights('path/to/yolov3_weights.h5')

# 打开视频流

cap = cv2.VideoCapture('path/to/video')

while cap.isOpened():

ret, frame = cap.read()

if not ret:

break

img = transform_images(frame, 416)

boxes, scores, classes, nums = yolo(img)

# 在帧上绘制识别结果

for i in range(nums[0]):

x1, y1, x2, y2 = boxes[0][i]

cv2.rectangle(frame, (x1, y1), (x2, y2), (0, 255, 0), 2)

cv2.putText(frame, f'{classes[0][i]}: {scores[0][i]:.2f}',

(x1, y1 - 10), cv2.FONT_HERSHEY_SIMPLEX, 0.9, (36,255,12), 2)

# 显示结果

cv2.imshow('frame', frame)

if cv2.waitKey(1) & 0xFF == ord('q'):

break

cap.release()

cv2.destroyAllWindows()本文介绍了基于深度学习的胃肠镜视频流炎症和病灶自动识别技术方案。从数据收集与标注、数据预处理、模型设计与训练,到系统集成与部署,详细描述了每一步的技术细节。通过该方案,可以构建一个高效的病灶识别系统,提升胃肠镜检查的效率和准确性。然而,实际应用中仍需不断优化模型和系统,以应对复杂多变的临床环境。未来,随着深度学习技术的不断进步,自动化病灶识别系统将在医学影像分析领域发挥越来越重要的作用。

典型应用介绍